外滩大会上,蚂蚁集团和中国人民大学联合研发原生MoE架构扩散语言模型(dLLM) LLaDA-MoE,在约20T数据上完成了从零训练MoE架构的扩散语言模型,验证了工业级大规模训练的扩展性和稳定性。该模型将在近期完全开源。

举报 第一财经广告合作,请点击这里此内容为第一财经原创,著作权归第一财经所有。未经第一财经书面授权,不得以任何方式加以使用,包括转载、摘编、复制或建立镜像。第一财经保留追究侵权者法律责任的权利。如需获得授权请联系第一财经版权部:banquan@yicai.com 文章作者

陈杨园

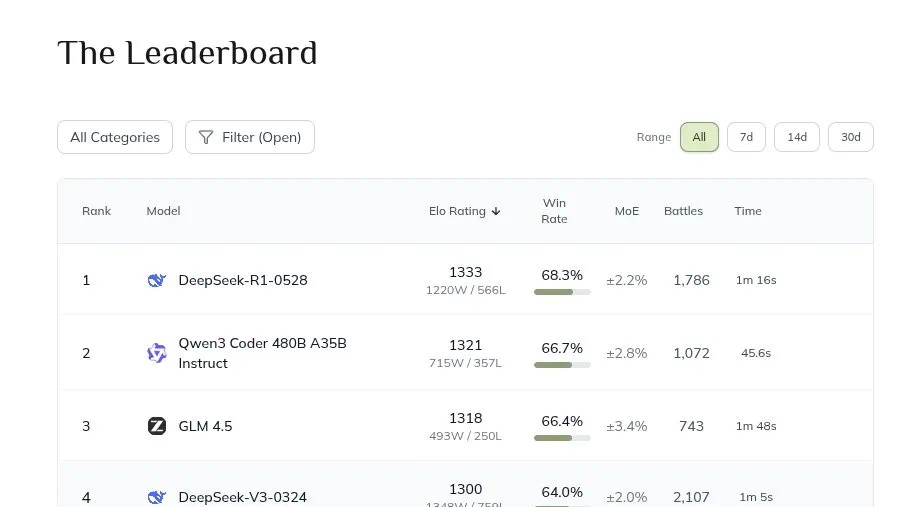

相关阅读 阿里发布下一代基础模型架构Qwen3-Next

阿里发布下一代基础模型架构Qwen3-Next训练成本仅为Qwen3-32B的十分之一不到。

68 3小时前 蚂蚁集团CEO首次表态通证经济

蚂蚁集团CEO首次表态通证经济韩歆毅强调,“通证经济的未来,必须深深植根于实体经济,才能真正释放价值。”

65 昨天 15:41 阿里云、美团同时出手,开源能成为机器人行业“催化剂”吗?

阿里云、美团同时出手,开源能成为机器人行业“催化剂”吗?只有当“开源”变成能跑得起来、落得下去的工具,行业才有望真正迎来通用具身智能的时刻。

127 09-08 16:41 AI进化速递丨“人工智能+”配套细则将出台

AI进化速递丨“人工智能+”配套细则将出台聚焦6大行动重点行业领域 “人工智能+”配套细则将出台;人工智能生成合成内容标识方法国家标准今起实施;OpenAI计划在“星际之门”重大扩展项目中设立印度数据中心。

82 09-01 20:43 中国模型厂商开辟“开源战场”,顶层设计再添一把火

中国模型厂商开辟“开源战场”,顶层设计再添一把火开源不只是单纯的技术手段,而会成为推动人工智能生态和产业落地的关键机制。

7 80 08-29 14:46 一财最热 点击关闭可靠股票配资网提示:文章来自网络,不代表本站观点。